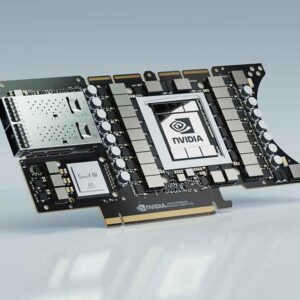

NVIDIA Enterprise anunció que la primera GPU basada en la arquitectura de Ampere de NVIDIA: NVIDIA A100, se está fabricando y enviando a los clientes de todo el mundo, después de recibir la mayor cantidad de pedidos previos a un lanzamiento en toda la historia de la compañía.

La A100 se basa en los avances de diseño de la arquitectura NVIDIA Ampere, que ofrece el mayor salto de rendimiento de la compañía hasta la fecha dentro de sus ocho generaciones de GPUs, para unificar el entrenamiento y la inferencia de IA y aumentar el rendimiento de hasta 20 veces más que los modelos precedentes. La A100 es un acelerador de carga de trabajo universal, que también está diseñado para el análisis de datos, la computación científica y los gráficos en la nube.

«Las poderosas tendencias de la computación en la nube y la IA están impulsando un cambio tectónico en los diseños de los centros de datos, de modo que lo que una vez fué un mar de servidores sólo de CPUs, ahora es la computación acelerada por el GPU», dijo Jensen Huang, fundador y CEO de NVIDIA. “La GPU NVIDIA A100 es un salto cuántico en el rendimiento de IA de 20 veces y un acelerador del aprendizaje automático de principio a fín, desde el análisis de datos hasta la capacitación y la inferencia. Por primera vez, las cargas de trabajo de ampliación y escalabilidad pueden acelerarse en una sola plataforma. NVIDIA A100 aumentará simultáneamente el rendimiento y reducirá el costo de los centros de datos».

Las nuevas tecnologías elásticas de cómputo integradas en A100 permiten aportar la cantidad adecuada de potencia de procesamiento a cada trabajo. La capacidad de GPU de múltiples instancias permite que cada GPU A100 se divida en hasta siete instancias independientes de «mini-GPUs» para realizar tareas de inferencia más pequeñas, mientras que la tecnología de interconexión NVIDIA NVLink® interconnect technology de tercera generación, permite que múltiples GPUs A100 funcionen como una GPU gigante, para cumplir con las tareas de entrenamiento cada vez más grandes.

Los principales fabricantes de sistemas y proveedores de servicios en la nube del mundo, que, planean incorporar las GPUs A100 a sus nuevas ofertas de productos y servicios de HPC, Ciencia de Datos e IA son: Alibaba Cloud, Amazon Web Services (AWS), Atos, Baidu Cloud, Cisco, Dell Technologies, Fujitsu, GIGABYTE, Google Cloud, H3C, Hewlett Packard Enterprise (HPE), Inspur, Lenovo, Microsoft Azure, Oracle, Quanta/QCT, Supermicro and Tencent Cloud.

Adopción inmediata en todo el mundo.

Entre las primeras empresas en aprovechar la potencia de las GPUs NVIDIA A100 está Microsoft, que aprovechará el rendimiento y la escalabilidad de la A100.

“Microsoft entrenó Turing Natural Language Generation, el modelo de idiomas más grande del mundo, para usar la generación actual de GPUs de NVIDIA”, dijo Mikhail Parakhin, Vice Presidente Corporativo, Microsoft Corp. “Azure planea entrenar modelos de IA mucho más grandes utilizando miles de GPUs NVIDIA A100 a escala para impulsar lo último en lenguaje, habla, visión y multimodalidad”.

DoorDash, es una plataforma de alimentos bajo pedido que ha servido como salvavidas para los restaurantes durante la pandemia, señala la importancia de tener una infraestructura flexible de Inteligencia Artificial.

“Las modernas y complejas cargas de trabajo de la inferencia y el entrenamiento en IA requieren una gran cantidad de datos que pueden beneficiarse de la tecnología de vanguardia como las GPUs NVIDIA A100, que ayudan a reducir el tiempo de entrenamiento del modelo y acelerar el proceso de desarrollo del aprendizaje automátizado». Gary Ren, ingeniero de aprendizaje automático en DoorDash, dijo: «Además, el uso de clústeres de GPUs basados en la nube nos brinda una nueva flexibilidad para ampliar o reducir según sea necesario, lo que ayuda a mejorar la eficiencia, simplificar nuestras operaciones y ahorrar costos».

Otros de los primeros adoptadores incluyen laboratorios nacionales y algunas de las instituciones de educación superior e investigación más importantes del mundo, cada una de las cuales usa A100 para potenciar sus supercomputadoras de próxima generación. Entre ellas se incluyen:

- La Universidad de Indiana, en los Estados Unidos, cuya supercomputadora Big Red 200 se basa en el sistema Cray Shasta de HPE, que respaldará la investigación científica y médica, y la investigación avanzada en inteligencia artificial, aprendizaje automátizado y análisis de datos.

- El Centro de Supercomputación Jülich, en Alemania, con el sistema de potenciamiento JUWELS, habiendo sido construido por Atos, que se diseñó para lograr una potencia de computación extrema y realizar tareas de inteligencia artificial.

- Karlsruhe Institute of Technology, en Alemania, que está construyendo su supercomputadora HoreKa con Lenovo, podrá llevar a cabo simulaciones multiescala significativamente más grandes en el campo de las ciencias de los materiales, las ciencias del sistema terrestre, la ingeniería para investigación en energía y movilidad, y la física de partículas y astropartículas.

- La Organización Max Planck de Datos y Computación, de Alemania, con su supercomputadora Raven de próxima generación construida por Lenovo, proporciona soporte de alto nivel para el desarrollo, optimización, análisis y visualización de las aplicaciones de computación de alto rendimiento a los Institutos Max-Planck.

- U.S. Department of Energy’s National Energy Research Scientific Computing Center, ubicado en el Laboratorio Nacional Lawrence Berkeley, que está construyendo su supercomputadora Perlmutter de próxima generación basada en el sistema Cray Shasta de HPE, para apoyar la ciencia a gran escala y desarrollar nuevas fuentes de energía, mejorar la eficiencia energética y descubrir nuevos materiales.

Cinco avances de A100.

La GPU NVIDIA A100 marca una revolución en el diseño técnico gracias a cinco innovaciones clave:

- Arquitectura Ampere: En el corazón de A100 se encuentra la arquitectura de GPU NVIDIA Ampere, que contiene más de 54,000 millones de transistores, lo que la hace el procesador de 7 nanómetros más grande del mundo.

- Third-generation Tensor Cores with TF32: Los núcleos Tensor de amplia adopción de NVIDIA ahora son más flexibles, rápidos y fáciles de usar. Sus capacidades expandidas incluyen nuevos TF32 for AI, que permiten un rendimiento de IA de hasta 20 veces mayor, con precisión FP32, sin cambiar el código. Además, los núcleos Tensor ahora permiten FP64, para lograr hasta 2.5 veces más de procesamiento de datos que la generación anterior, para las aplicaciones de HPC.

- GPU de múltiples instancias: MIG, una nueva función técnica, que permite que una sola GPU A100 se particione en hasta siete GPUs por separado, para poder proporcionar diferentes grados de procesamiento para trabajos de diferentes tamaños, lo que permite una utilización óptima y el máximo retorno de la inversión.

- Third-generation NVIDIA NVLink ™: Duplica la conectividad de alta velocidad entre las GPUs para proporcionar escalabilidad de rendimiento eficiente en un servidor.

- Baja densidad estructural: Esta nueva técnica de eficacia aprovecha la naturaleza ineherentemente escasa de los cálculos de IA para duplicar el rendimiento.

Juntas, estas nuevas características hacen que la NVIDIA A100 sea ideal para cargas de trabajo diversas y exigentes, que incluyen entrenamiento e inferencia de IA, así como simulación científica, IA conversacional, sistemas de recomendación, genómica, análisis de datos de alto rendimiento, modelos sísmicos y pronósticos financieros.

El modelo NVIDIA A100 está disponible en nuevos sistemas, y pronto llegará a la nube.

El NVIDIA DGX™ A100 system, que también se presentó hoy, cuenta con ocho GPU NVIDIA A100 interconectadas con NVIDIA NVLink. Ya está disponible mediante NVIDIA y socios autorizados.

Alibaba Cloud, AWS, Baidu Cloud, Google Cloud, Oracle and Tencent Cloud están planeando ofrecer los servicios basados en la A100.

Además, se lanzará una amplia variedad de servidores con A100 mediante los principales fabricantes de sistemas del mundo, como: , including Atos, Dell Technologies, Fujitsu, GIGABYTE, H3C, HPE, Inspur, Lenovo, Quanta/QCT and Supermicro.

Para ayudar a acelerar el desarrollo de servidores de sus socios, NVIDIA ha creado HGX A100, un componente fundamental de servidores en la forma de bloques de construcción, en la forma de zócalos integrados en múltiples configuraciones de GPUs.

La HGX A100 de cuatro GPUs ofrece una interconexión completa entre las GPUs con NVLink, mientras que la configuración de ocho GPUs ofrece un ancho de banda completo de GPU a GPU, a través de NVIDIA NVSwitch™. HGX A100, con la nueva tecnología MIG y su arquitectura de GPU de múltiples instancias, se puede configurar como 56 GPUs pequeñas, cada una más rápida que NVIDIA T4, hasta un servidor gigante de ocho GPUs con 10 petaflops de rendimiento de inteligencia artificial.

Optimizaciones de software de NVIDIA para A100.

NVIDIA también anunció varias actualizaciones de su paquete de software que permiten a los desarrolladores de aplicaciones aprovechar las innovaciones de la GPU A100. Esto incluye nuevas versiones de más de 50 bibliotecas CUDA-X que se usan para acelerar los gráficos, la simulación y IA; CUDA 11; NVIDIA Jarvis un marco de servicios de IA conversacional multimodal; NVIDIA Merlin, un marco de aplicación de recomendación profunda; y el and the NVIDIA HPC SDK, que incluye compiladores, bibliotecas y herramientas que ayudan a los desarrolladores de HPC a depurar y optimizar su código para A100.